Da diversi anni ho notato che riscuotono più interesse gli articoli al negativo, probabilmente perchè funzionano come la psicologia inversa, o forse perchè c’è una forma di masochismo insito nella rete nel cercare il negativo invece che il positivo, mah…

Molte volte ho visto e sentito parlare del problema dei file Braw, soprattutto oggi con i file più grandi e con un pensiero troppo … fluido nel gestire supporti e le loro caratteristiche, che poi è una scusa per non seguire le regole 😯 .

Cosa può dare problemi con i file Braw?

- La registrazione su un supporto sbagliato, non certificato

(la certificazione non è un semplice test di velocità, ma significa che bmd o qualche altro testano in molte condizioni diverse l’affidabilità del supporto dal primo all’ultimo byte, troppi elementi possono rompere la vostra catena di velocità e rovinare una ripresa) - Registrazione su supporto frammentato

(cancellare e scrivere i file da computer o altro) - Registrazione su un supporto non formattato dalla camera

(non molti sanno o non verificano quanti file nascosti sono scritti da certe marche, perché ovviamente ottimizzano le proprie camere) - Registrazione su supporto con un cavo sbagliato

(non tutti i cavi sono uguali) - Registrazione su supporto esterno con batteria insufficiente

(è un problema meno considerato, ma è la causa del 90% dei file corrotti su disco esterno, molte piastre per le batterie esterne hanno una doppia alimentazione 7,4v -12v, assicuratevi di collegarle al pin giusto a 12v). - Registrazione su un supporto non correttamente fissato alla videocamera durante le riprese in movimento

(usb c è il connettore più debole del mondo, un piccolo movimento può causare la disconnessione di un pin, sufficiente a rovinare la ripresa) - Spegnere la camera senza aspettare che smetta di lavorare sul supporto

(molte persone spengono la videocamera in modalità play. tornano alla modalità di registrazione e la spengono) - Registrare a un bitrate più alto/una qualità superiore a quella del supporto senza avvisare della mancanza di fotogrammi.

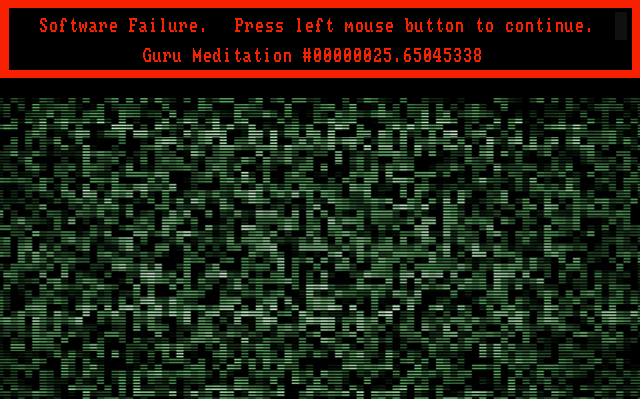

- Aprire il supporto da Windows e permettere che chkdsk faccia il suo lavoro per distruggere i dati (più frequente di quanto si pensi, non lasciare mai collegato il supporto esterno a Windows durante il riavvio, chkdsk naque per file molto piccoli, secoli fò, oggi quando agisce su file grandi causa al 99% solo danni)

- Abbassamento dell’energia durante la registrazione

(batteria scollegata o ignorata a fine vita, ricordate che quando la batteria si scarica, la videocamera inizia a ridurre l’energia al dispositivo esterno e successivamente si spegne, questo causa la corruzione del disco Cfast o Usb che chiude i file braw) - Aggiornamento del firmware del supporto

(a volte la frenetica mania di aggiornare tutto dimentica che tutta la catena si basa sul vecchio stato della catena e aggiornare qualcosa non è mai una buona cosa). - Copia di file senza controllo, oggi abbiamo uno strumento gratuito in Resolve per clonare il contenuto dei nostri file su un altro disco rigido, se non vi piace Resolve c’è un ottimo strumento gratuito chiamato QuineCopy https://www.quine.no/quinecopy.

Molto spesso i problemi dei file sono relativi alle copie non eseguite correttamente.

E a questo ne aggiungo uno, ma essendo superstizioso non lo chiamo 13

12.5 Uso del filesystem ExFat su file molto grandi.

Ove è possibile, Blackmagic ve lo permette, invece del filesystem ExFat usiamo il HFS+, nato in casa Apple e corrispettivo del più robusto NTFS di Micorsoft. Se usate Windows esiste un driver del costo di 12 euro per leggerlo e scriverlo come se fosse nativo (Paragon HFS+ for WIndows), saranno i soldi meglio spesi della vostra vita.

Il motivo è molto semplice, ExFat era nato per WindowsCE nel 2006, col il limite di pochi GB di dimensione massima (era per dei prodotti tascabili), e poi modificato in seguito per poter formattare e gestire supporti e archivi più grandi, ma…. purtroppo scrivendo file molto grandi questo filesystem è molto più sensibile a errori, a problemi nel recupero dei dati in caso di danni alla struttura del disco etc etc etc.

Quindi se avete la possibilità, evitate quel FileSystem, usiamo NTFS sotto Windows e HFS+ e successivi sotto Mac.

In caso di problemi di corruzione, ma i dati ci sono, un metodo per recuperare i dati è mostrato in questo video :

oppure si possono contattare Aeroquartet

La mia esperienza con BMCC, BMPC4K, Ursa Mini Pro G1, p4k, 2x p6k G1 ha dato, seguendo le regole, quasi zero problemi di file corrotti durante il lavoro 😀