Da tanti anni, sono annoiato da ciance sulla dimensione del sensore, sul fatto che sia indispensabile avere almeno un full frame (e il cinema è sempre stato fatto col s35 ovvero un aps-c circa come dimensione) altrimenti le immagini sono brutte, non si ha tridimensionalità, non raccoglie abbastanza luce etc etc

Sapete la cosa divertente? che tutti questi miti li ho sfatati negli anni con spiegazioni, prove tecniche di cosa faccia realmente la differenza e cosa cambi la tridimensionalità, gli spazi, la luce… il fatto che c’è chi lavora e chi invece deve prendere le misure…

La cosa triste è che nel 2025 ancora abbiamo questo mito, ma nessuno ha capito quale sia la vera differenza con un sensore più grande, e quale sia l’unica vera ragione per cui un sensore più grande fa la differenza sulla qualità d’immagine, e non è nulla di cui ho parlato sopra.

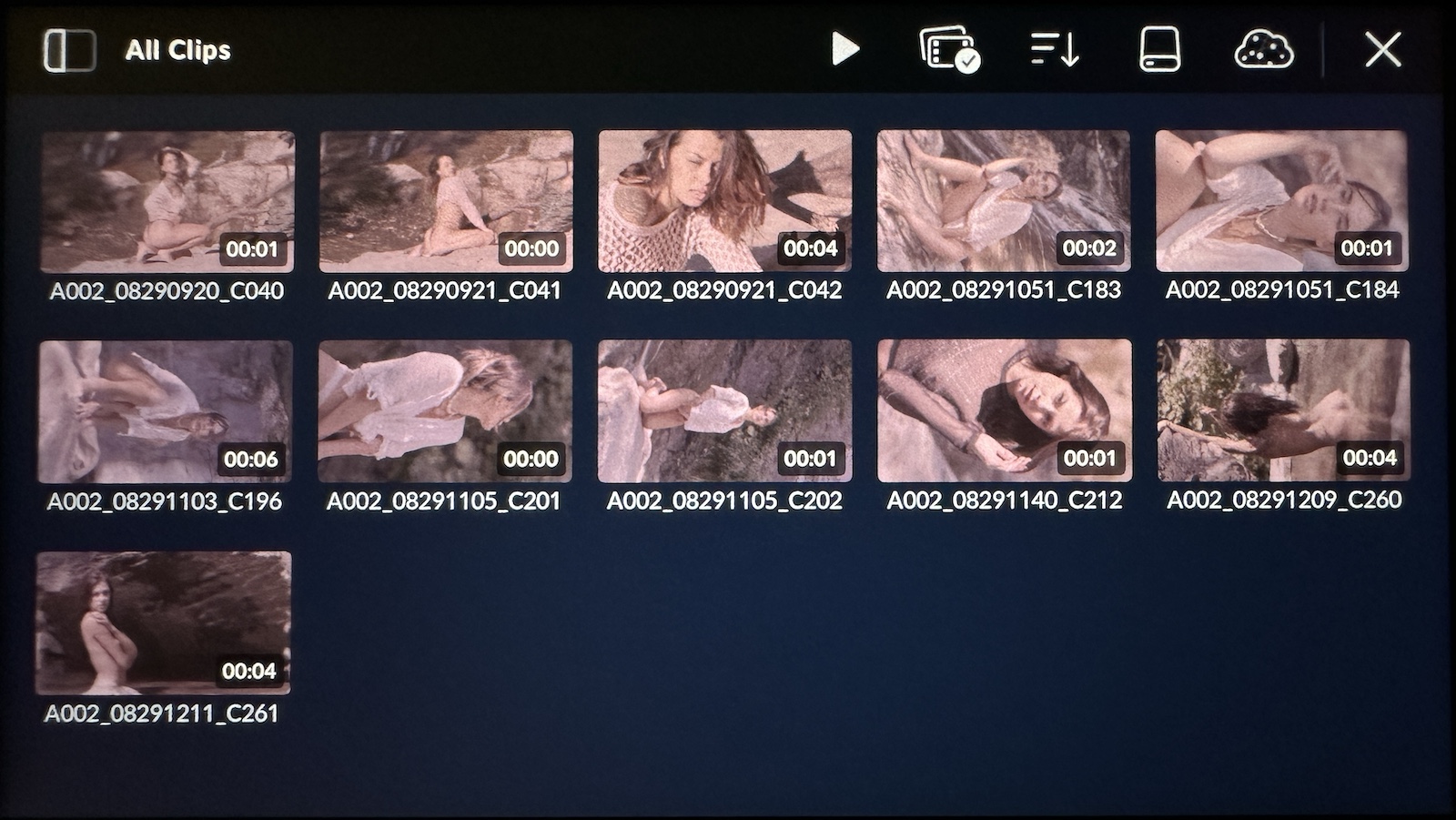

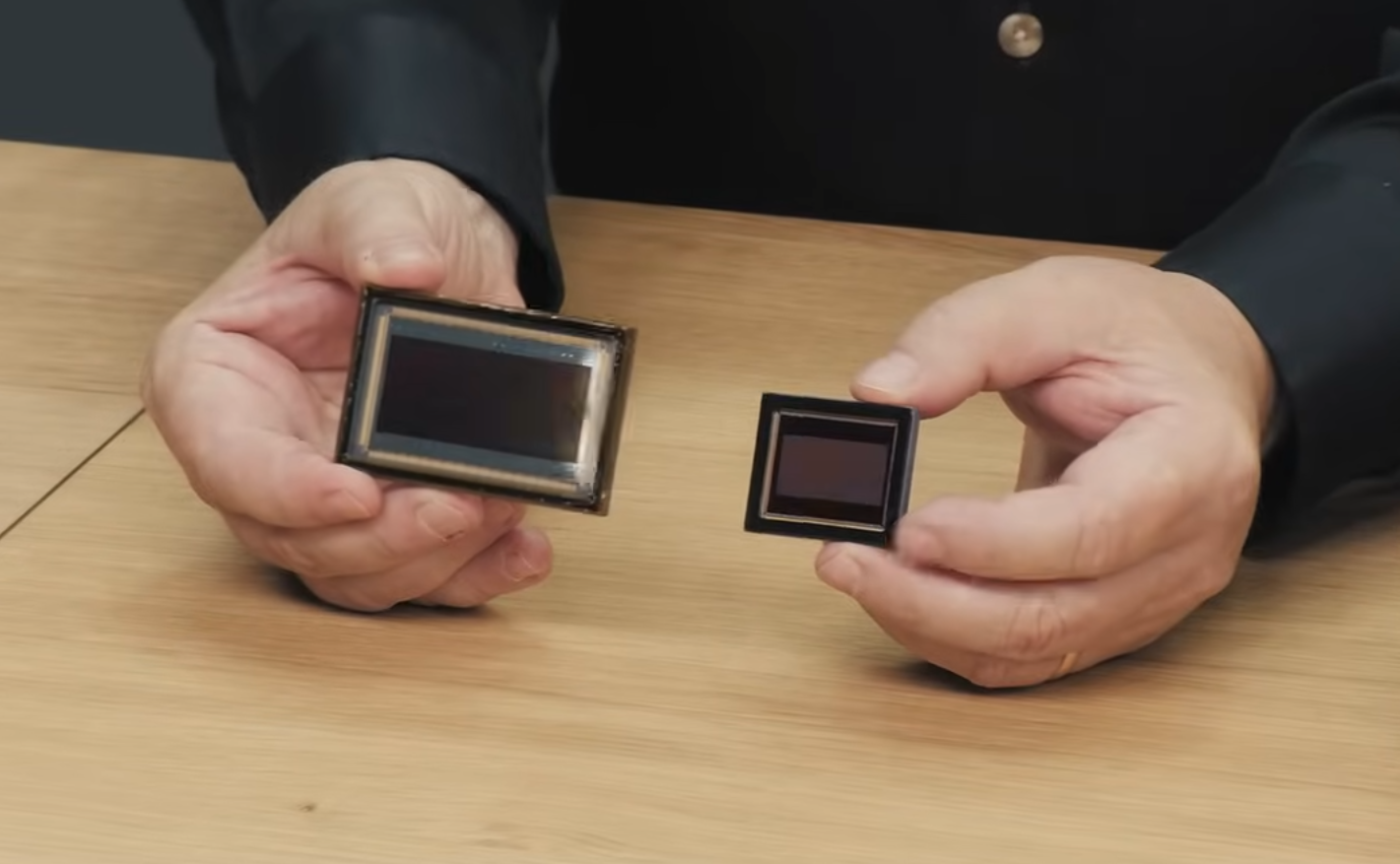

Il discorso oggi è tornato in auge per il fatto che Blackmagic a lanciato sia la 12k cine che la 17k con sensore da 65mm e tutti a ripetere il solito mantra, ma… c’è un motivo per cui quei sensori sono più grandi, e Blackmagic in questo caso ha solo percorso una strada già nota.

Il discorso oggi è tornato in auge per il fatto che Blackmagic a lanciato sia la 12k cine che la 17k con sensore da 65mm e tutti a ripetere il solito mantra, ma… c’è un motivo per cui quei sensori sono più grandi, e Blackmagic in questo caso ha solo percorso una strada già nota.

In realtà diverse aziende ne erano consce, per questa ragione le Arri Alexa avevano sensori da 3.5k, in open gate e poi scendevano a 2.7k in ripresa 1.85.

Sony quando fece determinate fotocamere orientate al video come la Sony A7S2 in poi, anche se aveva la serie R (resolution) per il video avevano una serie meno risoluta in rapporto alla dimensione del sensore, e tutto questo non per raccogliere più luce, come in tanti hanno erroneamente scritto, ma per un principio che i vecchi fotografi conoscevano bene e che oggi molti hanno dimenticato : la diffrazione.

La diffrazione cos’è e come si calcola

La diffrazione è quel fenomeno ottico per cui data una certa dimensione di piano focale/sensore, data una certa dimensione di foro attraverso il quale entra la luce, esiste un limite fisico non modificabile per cui alla riduzione del foro (diaframma) la luce verrà proiettata in modo non corretto sulla superficie dando adito al fenomeno di Diffrazione, che causerà una immagine meno nitida.

In pratica? in funzione della dimensione del sensore, della risoluzione dello stesso, del valore di chiusura del diaframma, se si chiude più di un tot, l’immagine perderà di nitidezza.

Quindi se alziamo la risoluzione di cattura, a parità di dimensione di sensore, dovremo tenere il diaframma più aperto di un tot, altrimenti l’immagine sarà meno nitida.

Quindi se vogliamo girare in deep focus, dobbiamo tener conto di questo fattore e conoscere quale sia il limite della nostra camera/ottica, altrimenti potremo trovarci in una situazione assurda in cui chiudendo il diaframma ridurremo la nitidezza finale dell’immagine.

E ci sono cascato anche io facendo questa immagine, dove ho chiuso troppo il diaframma.

Il criterio di Rayleigh

metodo matematico per dare un numero al minimo dettaglio risolvibile quando un sistema di imaging è limitato dalla diffrazione.

θ=1,22λ/D

Dove θ è in radianti, λ è la lunghezza d’onda della luce verde; .55μm , D è il passo dei pixel; 2,2μm.

Il diametro del disco aereo è circa 2-3 volte il passo del pixel. Questo perché il pixel pitch corrisponde alla distanza tra il centro di due pixel adiacenti, il più piccolo dettaglio risolvibile, e il diametro coprirebbe almeno due pixel. F/stop è 1/2 dell’inverso dell’apertura numerica (NA), perché θ è in radianti.

Scriviamo questo valore come il più piccolo f/stop risolvibile:

f/stop = 2D/2,44λ

Cioè, due pixel coperti e 2 radianti fanno 1 apertura numerica, il cui inverso è l’f/stop.

Per l’UMP12K è 2 x 2,2 / 2,44 x .55 = f/3,3

Per la Cine12K è 2 x 2,9 / 2,44 x .55 = f/4,3

Per la Pocket 6K 2 x 3,8 / 2,44 x .55 = f/5,7

Per l’UMP4.6G2 sono 2 x 5,5/ 2,44 x. 55 = f/8,2

Per il BMCC6K 2 x 6,0 / 2,44 x .55 = f/8,9

Se accettiamo 3 pixel coperti dal disco d’aria anziché solo due, possiamo abbassare lo stop per ottenere:

Per l’UMP12K, sono 3 x 2,2 / 2,44 x .55 = f/4,9

Per la Cine12K, 3 x 2,9 / 2,44 x .55 = f/6,5

Per la Pocket 6K, 3 x 3,8 / 2,44 x .55 = f/8,5

Per l’UMP4.6G2 sono 3 x 5,5/ 2,44 x .55 = f/f12,3

Per il BMCC6K, 3 x 6,0 / 2,44 x .55 = f/13,4

Come si può notare, la diffrazione pone un limite ai minimi dettagli fisici. Man mano che il passo dei pixel diventa più fitto, il sensore supererà la risoluzione dell’obiettivo con aperture di f/stop minori.

Da questi semplici calcoli si evince due cose fondamentali, conoscere la propria camera ci permette di usarla al meglio, conoscere le basi della fotografia ci permette di evitare una serie di problemi tecnici pratici non scontati.

Da questo semplice calcolo abbiamo anche capito perchè è meglio lavorare con filtri ND di vario tipo e non chiudere troppo i diaframmi se lavoriamo con sensori molto densi, altrimenti è inutile avere risoluzioni alte, perchè le sprecheremo otticamente.

Ora la domanda che sorgerà spontanea in tante teste dovrebbe essere : ma tutti quei cellulari con 100 mpx e un sensore grande quanto una capocchia di spillo? 😀

buoni calcoli