Dalla prima Cinema Camera di Blackmagic ho sempre lasciato un commento su di esse, ne ho possedute diverse, ne possiedo diverse, e trovo che siano prodotti molto interessanti per diverse ragioni, spesso non quelle mainstream su cui tutti si entusiasmano.

Tutti a gridare al miracolo perchè è una fullframe, sensore più grande di quello classico cinematografico super 35, come se fosse la panacea di tutti i mali, o la secret sausage per l’effetto cinema (che ricordiamo il formato classico del cinema è più piccolo…).

Le specifiche le hanno sbandierate tutti e se vi interessa, basta andare sulla pagina dedicata qui.

Analizziamo quello che io ritengo più interessante di questa camera e perchè :

Open Gate 3:2 : finalmente la possibilità di girare in un formato non spinto in larghezza, concetto che deriva dal cinema delle origini, che molti registi moderni (da Sam Raimi a Wes Andreson) hanno sfruttato nelle cineprese Arri per creare dei formati con proporzioni particolari e quindi usarli come metodo narrativo.

Open Gate 3:2 : finalmente la possibilità di girare in un formato non spinto in larghezza, concetto che deriva dal cinema delle origini, che molti registi moderni (da Sam Raimi a Wes Andreson) hanno sfruttato nelle cineprese Arri per creare dei formati con proporzioni particolari e quindi usarli come metodo narrativo.

Opzione che introduce il Multi Aspect ratio che permette di fare riprese tradizionali, Anamorfiche, e molte combinazioni di formati e frame rate per risolvere ogni tipo di necessità di ripresa.

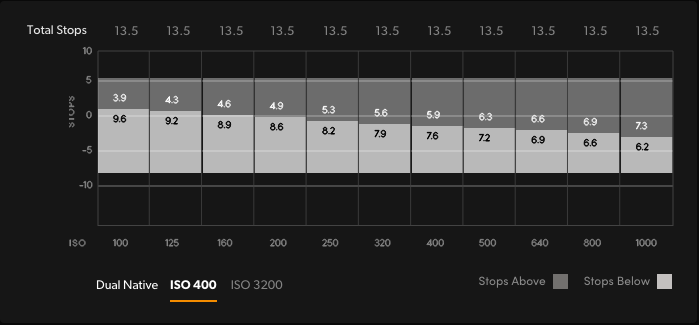

Nuovo Sensore Dual ISO a 13.5 stop di DR nel primo stage di gain : molti parlano di gamma dinamica, ma non sanno che la maggior parte delle camere hanno la gamma dinamica massima SOLO ad Iso nativo, spostandosi non offrono lo stesso range di dinamica, mentre qui troviamo lo stesso range spalmato sui diversi ISO.

Nuovo Sensore Dual ISO a 13.5 stop di DR nel primo stage di gain : molti parlano di gamma dinamica, ma non sanno che la maggior parte delle camere hanno la gamma dinamica massima SOLO ad Iso nativo, spostandosi non offrono lo stesso range di dinamica, mentre qui troviamo lo stesso range spalmato sui diversi ISO.

Proxy H264 creati in parallelo con i file Braw, per semplificare sia la preview che l’editing che l’utilizzo del Blackmagic Cloud dove si possono caricare i materiali e iniziare a lavorare prima ancora di aver ricevuto i raw derivati.

CfExpress per la registrazione ad alta velocità.

In passato ci sono state tante polemiche relative alle card SD (quelle veloci costano un rene) e le Cfast che non sono mai scese di prezzo, mentre le CfExpress oltre ad esser state adottate da diversi brand, sembrano già essere più economiche delle equivalenti Cfast2 o delle SD v90 (ovviamente si fa confronto tra prodotti simili per prestazioni, non la microsd da cellulare che non sarebbe in grado neanche di registrare i frame in raw).

Display 5 pollici HDR 1500 nits articolato ereditato dalla pro, per rendere più semplice l’uso della camera in pieno sole e non dover aggiungere ulteriori monitor. Poi se si preferisce, c’è sempre il Viewfinder Blackmagic già in uso per pocketG2 e 6kPro.

Display 5 pollici HDR 1500 nits articolato ereditato dalla pro, per rendere più semplice l’uso della camera in pieno sole e non dover aggiungere ulteriori monitor. Poi se si preferisce, c’è sempre il Viewfinder Blackmagic già in uso per pocketG2 e 6kPro.

Infine, anche se non meno importante L mount, per poter montare ottiche di alto livello, o con semplici adattatori le classiche lenti da EF ad altre, avendo il mount L una flangia molto corta di 20mm.

Infine, anche se non meno importante L mount, per poter montare ottiche di alto livello, o con semplici adattatori le classiche lenti da EF ad altre, avendo il mount L una flangia molto corta di 20mm.

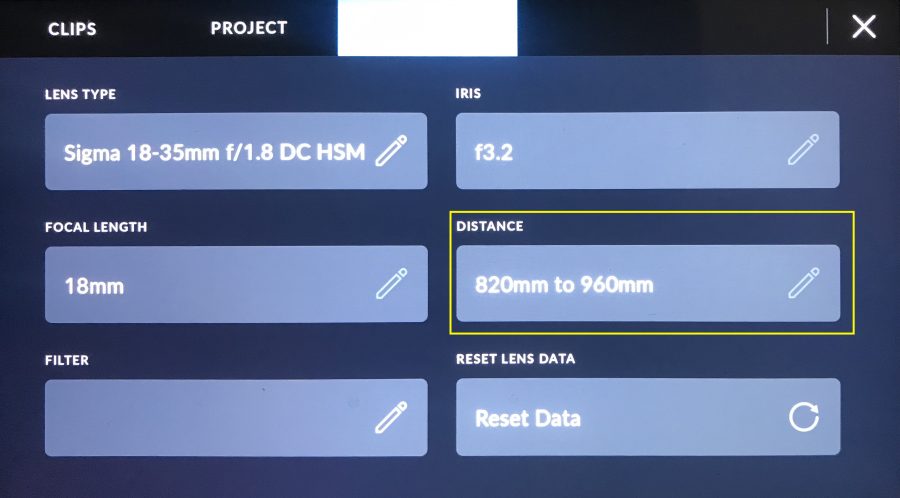

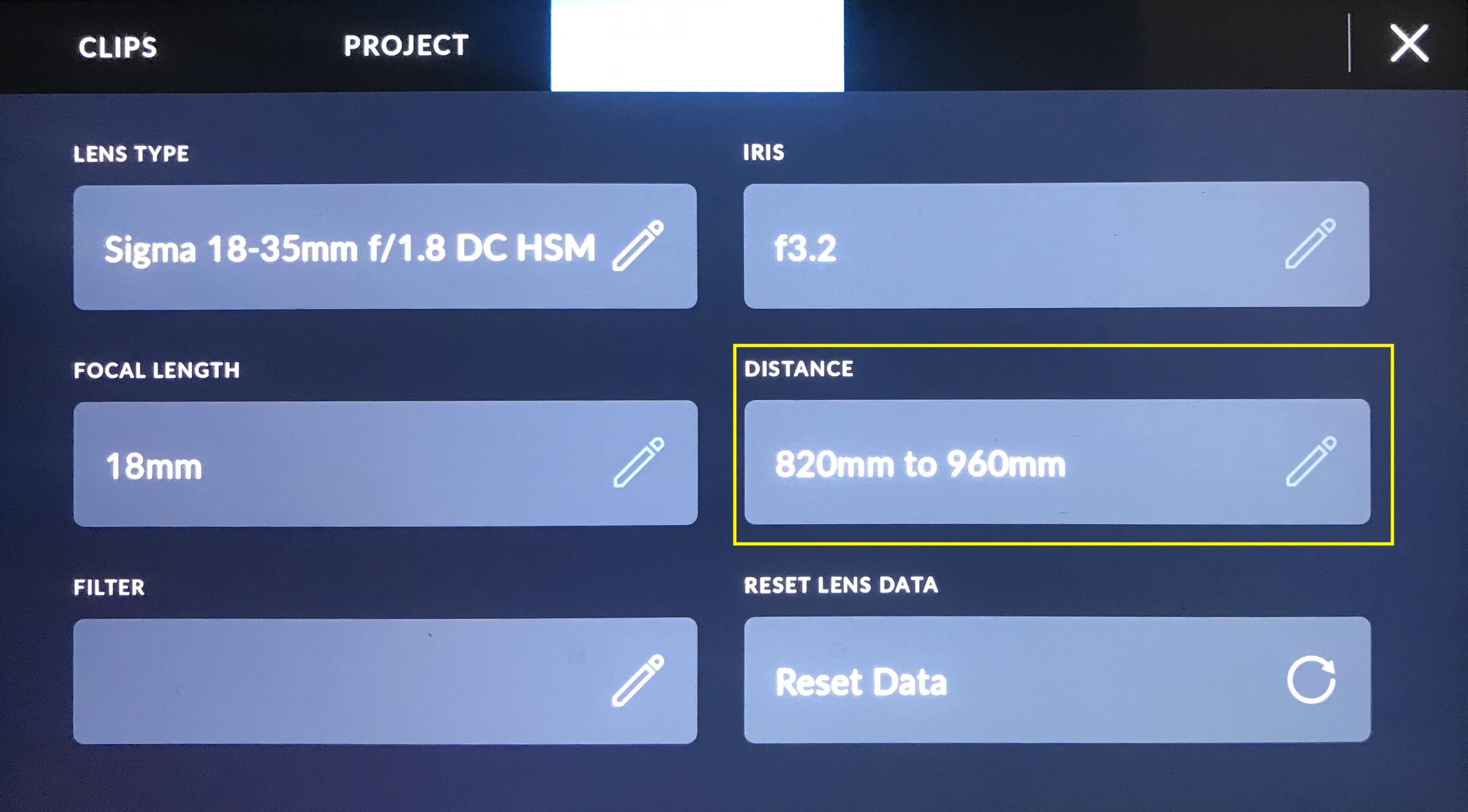

La reale differenza nell’usare L mount è che oltre ad avere un prodotto con un attacco più moderno, fa parte di un consorzio che ha completamente diffuso i dati per supportare nel modo corretto e migliore la gestione delle lenti, al contrario del mount EF che viene adottato da più marchi, ma sempre e solo con un lavoro di Reverse engeneering del mount, dell’elettronica e della comunicazione, il che porta poi a problematiche di gestione camera lente.

per ridurre gli eventuali effetti moires con tessuti o altri elementi, ad esempio i ledwall, che oggi sono sempre più presenti come sfondi o elementi di scenografia. Inoltre è elemento fondamentale (pare) per avere quella mitica certificazione di NetFlix… per chi gli interessa.

Di solito ironizzo sulle accezioni che vengono fuori dai soliti incontentabili, che comunque non comprano, stanno solo dietro le tastiere a lamentarsi…

questa volta… ma anche no…

Non credo che farò un upgrade a breve perchè molte ottiche moderne che posseggo sono aps-c (funzionerebbero ugualmente perchè nelle diverse modalità ha anche il crop per aps-c), mentre quelle vintage sono ovviamente Fullframe.

Però se Blackmagic vuole regalarmene una per il mio progetto di fotografare con una Cinema Camera, per vederne gli effetti alternativi 😀

Intanto in una mattinata di sole, mi ha permesso di catturare delle immagini interessanti, e anche se ho dovuto dimezzarne la dimensione per una questione puramente tecnica (il sito non mi permetteva di caricare frame in 6k nella gallery) direi che si può apprezzare la qualità dei singoli frame.