Le batterie che normalmente usiamo in ambito informatico e filmaking si basano sulla tecnologia degli ioni di litio, una tecnologia che ha visto tante evoluzioni negli ultimi anni.

Le batterie che normalmente usiamo in ambito informatico e filmaking si basano sulla tecnologia degli ioni di litio, una tecnologia che ha visto tante evoluzioni negli ultimi anni.

Ci sono tanti miti e leggende che trovano fondamento solo nelle prime versioni delle batterie agli ioni di litio, le moderne batterie hanno meno problemi rispetto alle precedenti tecnologie, ma ovviamente hanno dei limiti temporali di durata e un massimale di cariche e ricariche, per cui un buon uso delle batterie e una buona manutenzione è una buona abitudine per massimizzare la resa e soprattutto la durata della vita delle batterie.

Senza andare nel tecnico, una batteria è carica quando ha una differenza di potenziale tra positivo e negativo di un certo valore.

La batteria esprime il suo potenziale in Volt e ampere, quindi quando va caricata si applicherà un certo voltaggio e un certo amperaggio per ripristinare questa differenza di potenziale.

Durante la fase di carica il dispositivo / la batteria “chiede” la carica e il caricatore “offre” la potenza di carica fino al suo massimo valore di carica in Volt / Ampere.

La vita di una batteria

La durata della capacità di conservare ed erogare la carica è determinato da una serie di fattori:

- numero di cicli di carica – scarica eseguiti

- temperatura a cui è stata sottoposta la batteria

- carica veloce vs carica lenta

- età della batteria (anni trascorsi dalla creazione della batteria)

Numero di cicli di carica

Le batterie hanno un numero pressochè finito di cicli di cariche e scariche, che normalmente superano ampliamente la vita della batteria, quindi non dobbiamo preoccuparci di quante volte andremo a caricare una batteria. Un numero di cicli comune è intorno ai 1000 cicli fino ad arrivare a 8000 cicli di ricarica per alcune batterie di alta qualità. Ipotizzando di usare la batteria tutti i giorni, ricaricandola tutti i giorni si potrebbe ricaricarla per circa 3 anni senza avere ripercussioni sulla batteria.

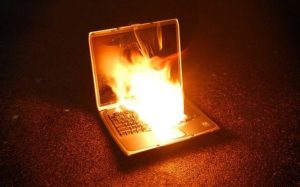

Il caldo è il suo nemico

Il caldo generato dalla carica/scarica o quello esterno alla batteria dispositivo alimentato dalla batteria, influisce sulla qualità degli elementi chimici contenuti dentro la batteria e la loro capacità di lavoro.

Il caldo generato dalla carica/scarica o quello esterno alla batteria dispositivo alimentato dalla batteria, influisce sulla qualità degli elementi chimici contenuti dentro la batteria e la loro capacità di lavoro.

Molte persone trattano male le batterie, le abbandonano scariche, al freddo, al caldo e tutte queste operazioni influiscono in modo netto sia sulle prestazioni che sulla durata di tenuta della carica delle batterie.

Carica Veloce vs Carica Lenta

Quando carichiamo una batteria da 12v possiamo usare un alimentatore da 12v 1 ampere oppure da 6v 2 ampere, la differenza tra i due casi è che con un amperaggio maggiore possiamo accelerare la carica, ma ciò genera un maggior calore, che non fa bene alla batteria e potrebbe dare danni ai cablaggi. Quindi l’uso della carica veloce, potrebbe usurare maggiormente la capacità della batteria di conservare la carica. Uso il condizionale perchè questa usura è determinata più dalla generazione del calore che da un danno chimico, quindi dipende dalla situazione, dal sistema di carica e dalla gestione della carica. Molti caricabatterie contengono chip di controllo della carica che monitorano la situzione e gestiscono l’amperaggio in uscita.

Età della batteria

L’unico vero difetto delle batterie al litio è che hanno una durata limitata, e quindi è importante conoscere la data di produzione della batteria perchè man mano che passa il tempo la capacità andrà a scendere in modo fisiologico, quindi anche quando acquistiamo le batterie per i dispositivi è importante verificare la data di produzione.

Conservazione

Quindi riassumento per conservare correttamente una batteria la strategia migliore è :

- Fare un refresh della carica ogni 4-6 mesi.

- Conservare in luogo fresco e asciutto.

- Non lasciar scaricare la batteria a 0%.

- Possono essere lasciate fino 40% di carica.