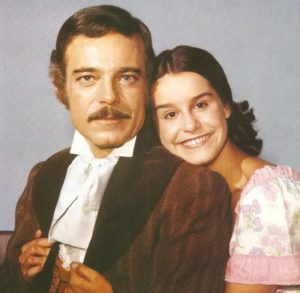

La schiava Isaura, la prima telenovelas della storia.

Un po’ parafrasando una frase detta da una persona a Cannes, che la digitalizzazione delle pellicole sarebbe capace di trasformare Barry Lyndon in una telenovelas, un po’ perchè oggi tra gli addetti al settore si dice che una certa immagine è “da telenovelas” ho deciso di scrivere due righe a proposito di uno drammi moderni nel vedere un film con una televisione : la rielaborazione delle immagini.

Grazie all’avvento della teorica alta definizione casalinga, parlo di teoria perchè molti canali televisivi trasmettono sui canali hd film da master in definizione standard, oppure solo ogni tanto trasmetto in hd qualcosa, le case di tutto il mondo si sono riempite di brillanti e molto contrastati televisori per vedere telegiornali e ogni tanto anche un film.

La battuta non è causale perchè tutti i televisori moderni, anche e soprattutto se hanno una definizione superiore come il 4k sono pensati principalmente per riprodurre materiale in definizione molto scarsa, e come tale da essere rielaborata perchè altrimenti le “persone sarebbero scontente del televisore”, ho letto la settimana scorsa di una persona che si lamentava della mancanza di definizione di un televisore 4k nel vedere le partite, non su canali dedicati in hd, ma sulla semplice rai SD, e la lamentela continuava dicendo che essendo il televisore 4k tutto doveva essere migliore… e che lo avrebbe cambiato a breve col marchio x che le fa vedere meglio…

è per questo tipo di persone che rappresentano il pubblico medio che ci dobbiamo sorbire immagini orribili quando andiamo a vedere immagini di qualità.

La spiegazione è molto semplice: tarando i televisori per immagini che sono forse un quarto della definizione (trasmissione fhd) o addirittura un sedicesimo della definizione del 4k, i pixel devono essere gonfiati, e quindi come tali si vedrebbero delle immagini sfuocate o di pessima qualità, quindi vanno rielaborate per sembrare migliori. Il concetto andrebbe bene se la manipolazione fosse progressiva e dosata sulla sorgente, ovvero se forniamo al televisore immagini di risoluzioni superiori o adatte alla matrice del televisore questi algoritmi si dovrebbero disabilitare, invece lavorano comunque alterando immagine, colore, contrasto, e addirittura il movimento percepito delle immagini purtroppo non tutti gli algoritmi di rielaborazione sono modificabili o diabilitabili, addirittura ogni produttore nasconde dietro nomi diversi le diverse funzioni e alcuni impediscono la disabilitazione se non sui segnali in ingresso sulle HDMI, per cui anche ricevendo un ottimo segnale 4k da netflix, devo usare un dispositivo con ingresso esterno per evitare che venga manipolato dal televisore rovinandolo.

Ora vediamo all’atto pratico cosa succede e come le immagini vengono alterate.

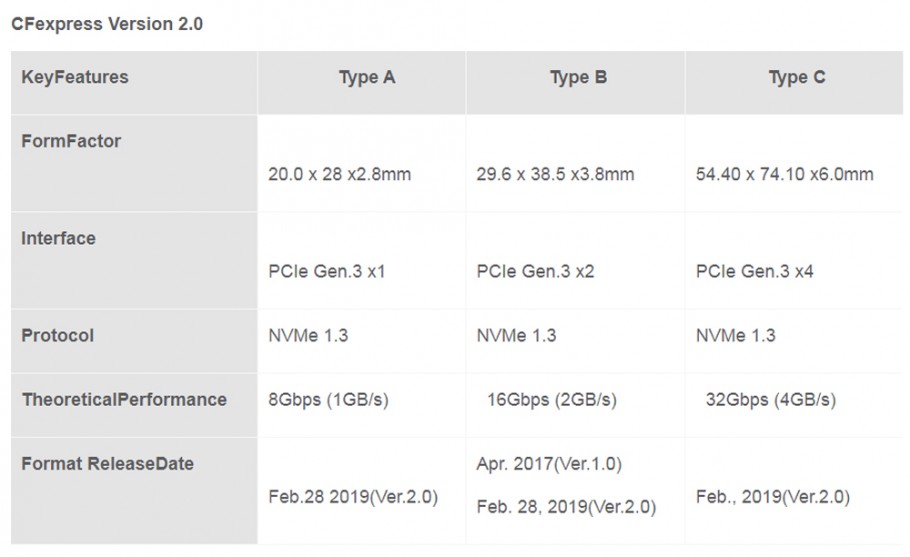

Qui vediamo la situazione più comune, una immagine nativa 4k vs l’equivalente trasmessa in SD, come trasmettono la maggior parte dei canali oggi nel 2018, se non mi credete andate nelle info del canale sul vostro televisore e guardate lo stream a che definizione viene inviato.

Ricordo che una classica immagine UHD è fatta da 3840 x 2160 pixel, il FHD da 1920×1080 pixel (esattamente la metà in orizzontale e verticale, quindi un quarto), il formato HD è 1280 x 720 pixel, e infine l’SD è solo 720×576 pixel rettangolari, perchè naque in un formato più quadrato e quindi per ottenere una scalatura su matrici moderne oltre che scalato viene distorto in orizzontale.

[twentytwenty]

[/twentytwenty]

[/twentytwenty]

Come si può notare la differenza tra UHD (4ktv) e il formato Standard visti al 100% è notevole, perchè abbiamo una differenza di sedici volte delle informazioni visibili, quindi ingrandendo il segnale SD si vede in modo evidente la differenza.

Dato che i dettagli non si possono inventare, in queste situazioni non si può fare nulla, tranne masticare le immagini con algoritmi varii per fingere che ci sia contrasto dove non esiste, ma con immagini con dettagli fini come questi, il problema della scarsità di qualità rimane.

[twentytwenty]

[/twentytwenty]

[/twentytwenty]

Se invece andiamo a lavorare con un pò più di risoluzione, ovvero con il formato HD, già il salto non è così disturbante, e potrebbero lasciare le immagini alla loro natura.

[twentytwenty]

[/twentytwenty]

[/twentytwenty]

Se potessimo vedere sempre immagini in FHD su televisori FHD o 4k, la scalatura diventa minore e quindi meno evidente, anche se presente.

L’elemento che ci inganna è il fatto che ogni segnale viene processato in più modi e la stessa immagine riceve più trattamenti, dalla cosiddetta clarity che spinge luci e ombre in due estremi, alle maschere di contrasto per rendere più definiti dettagli che non possono essere definiti perchè troppo grossolani, oppure anche se il dettaglio è presente in modo corretto, lo rende artificiale perchè applica la maschera in modo lineare su tutta l’immagine.

[twentytwenty]

[/twentytwenty]

[/twentytwenty]

quindi nella realtà non vedremmo una immagine in cui ci sono poche differenze tra fhd e 4k, ma vedremmo una immagine rielaborata del FHD creando articialmente difetti e artefatti dove non servono.

Quando vediamo una telenovelas è normale una certa piattezza di luce perchè per risparmiare tempo e non rischiare differenze tra una inquadratura e l’altra si rende molto più piatta e uniforme l’illuminazione, dato che si gira con telecamere la paura di non avere immagini nitide porta ad alzare parametri di nitidezza artificiale in camera, inoltre i sensori delle camere da studio sono tali per cui non si hanno grosse sfumature e differenze tra le diverse colorimetrie del set e i diversi incarnati. In pratica esattamente l’opposto di ciò che si fa con i film per dare il look cinematografico.

[twentytwenty]

[/twentytwenty]

[/twentytwenty]

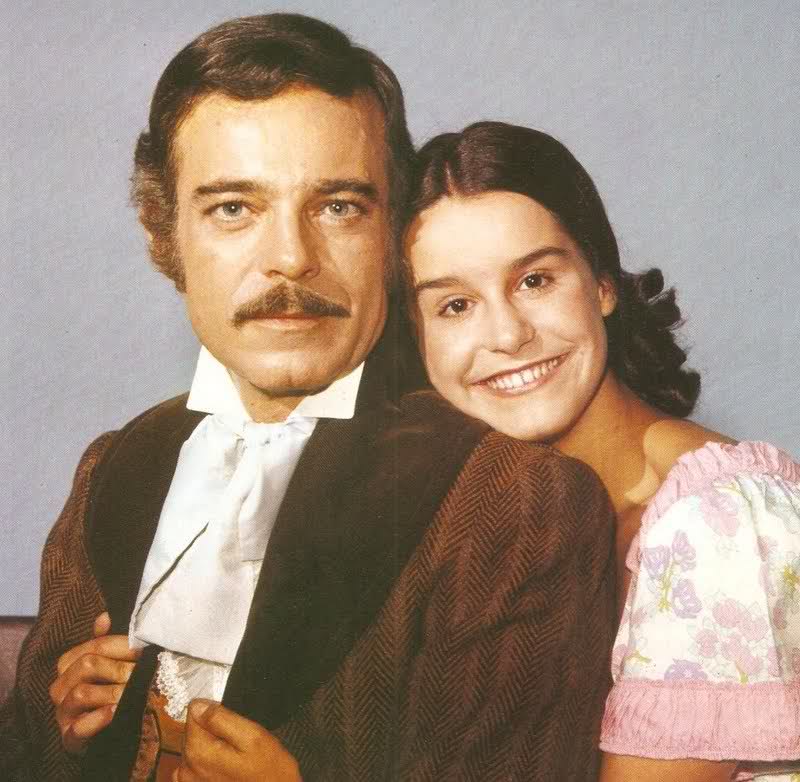

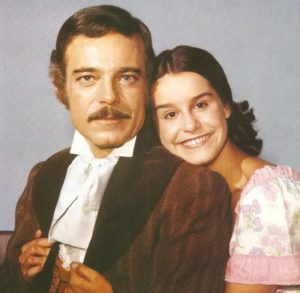

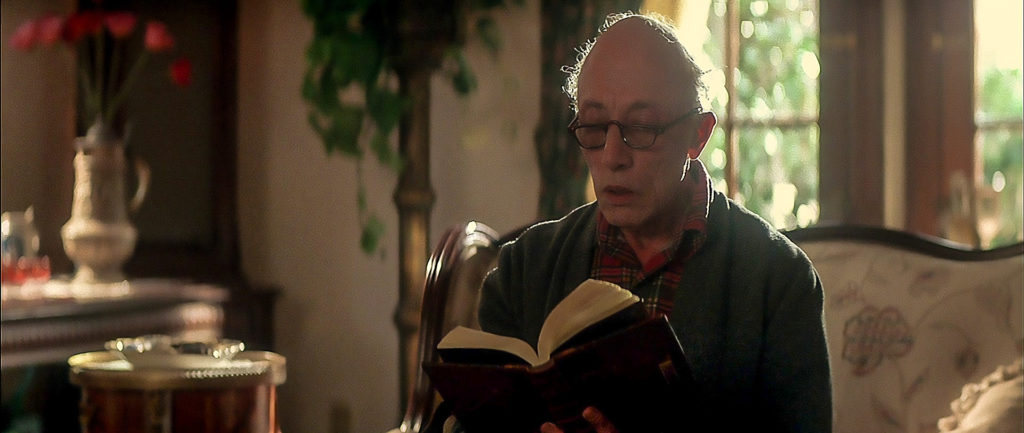

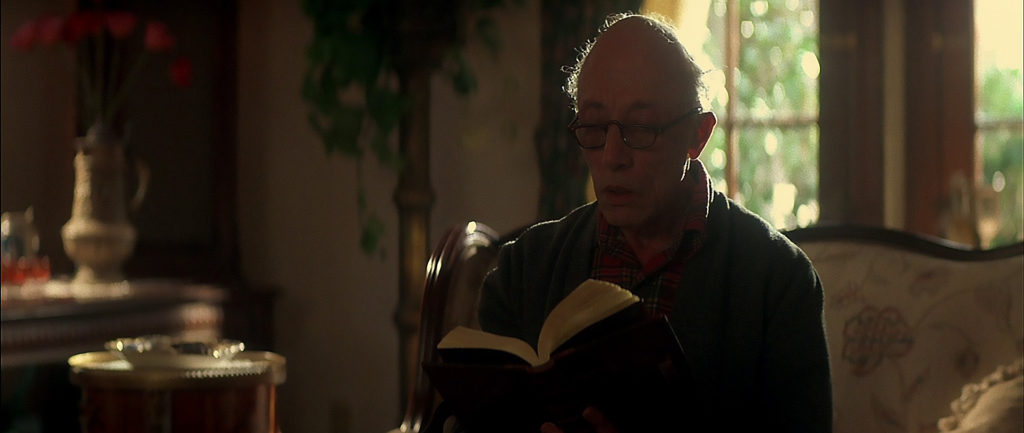

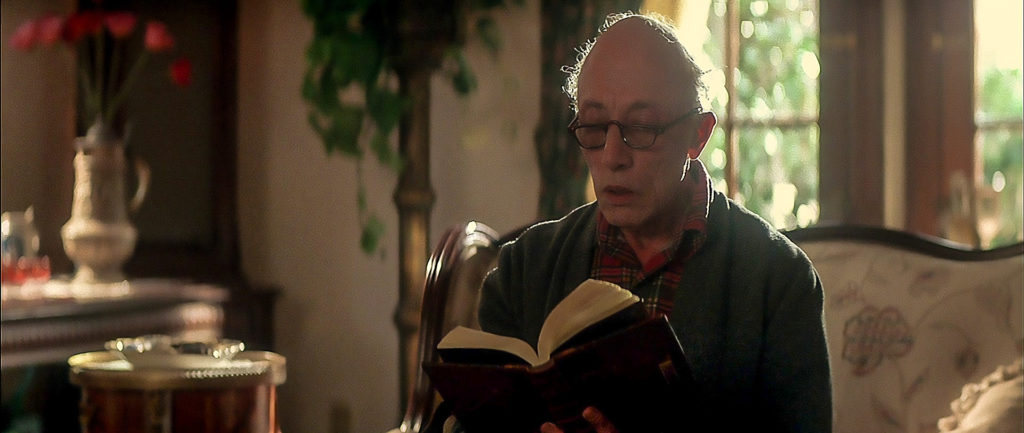

Prendiamo una immagine dal bluray di MonsterSquad, un classico teenager movie anni 80 a cui serie come Stranger Things devono tutto, mettiamola su un normale televisore, il risultato nel migliore dei casi sarà come quello che vedete qui sotto, ovvero una versione telenovelizzata dell’immagine originale, con applicata la tecnica della clarity per dare maggior contrasto locale all’immagine, una maschera di contrasto per definire tutti i dettagli dell’immagine, rovinando completamente l’atmosfera dell’immagine, appiattendo l’immagine dove il direttore di fotografia aveva deciso separando con luce e ombra i due piani. E’ molto evidente se si guarda come vengano fuori gli elementi dalle ombre dietro l’attore, distraendo e comprimendo lo spazio intorno ad esso.

Naturalmente non può mancare una forte riduzione rumore perchè di sicuro tra compressione e trasmissione si creerà rumore che assolutamente non può essere accettato, peccato che venga eliminata spesso in questo modo anche la grana e la struttura della pellicola, oltre ad eliminare il dettaglio fine.

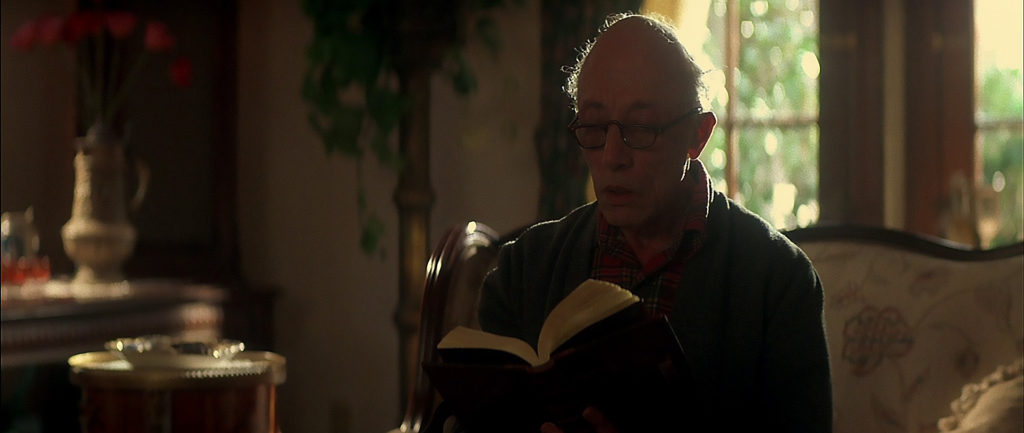

Il dettaglio artificiale dato dalla maschera di contrasto esalta in modo eccessivo i capelli dell’anziano protagonista, ma accentua anche i dettagli fuorifuoco alla sua destra, perchè purtroppo l’algoritmo viene applicato in modo piatto e uniforme ad ogni parte dell’immagine, mentre nella realtà se abbiamo una parte nitida (a fuoco) e una morbida (fuorifuoco) la nitidezza naturale è dosata e distribuita aumentando la sensazione di profondità delle immagini.

Queste tecniche potrebbero aiutare una immagine debole, ma se applicate ad una buona immagine la rendono molto più televisiva e piatta, rovinando il lavoro di un buon direttore di fotografia, e non solo. Inoltre andrebbero dosate inquadratura per inquadratura, area per area con delle maschere, per poter dare un vero contributo all’immagine, invece su qualunque televisore applicano questi effetti in modo piatto su tutta l’immagine rovinando in più punti la resa della fotografia.

Il buon Stu di ProLost, esperto di vfx, colore e immagini ha fatto un ottimo post su come non solo rovinino le immagini a livello colore e contrasto, ma rielaborino anche il movimento e la percezione dello stesso, creando artificialmente fotogrammi superflui, che diventano necessari perchè gli originali essendo stati troppo contrastati hanno perso la loro originale sfuocatura di movimento e sono diventati scattosi… insomma un serpente che si morde la coda…

Chiudiamo il discorso con un paio di immagini pubblicitarie che ci fanno capire come il brutto vizio di manipolare le immagini non è una derivazione moderna, ma da tanti anni abbiamo il problema di poter vedere ciò che i direttori di fotografia hanno pensato in origine, solo che una volta sui tubi con l’immagine analogica le rielaborazioni erano limitate, oggi purtroppo si può massacrare ogni immagine oltre ogni limite della decenza.

Chiudiamo il discorso con un paio di immagini pubblicitarie che ci fanno capire come il brutto vizio di manipolare le immagini non è una derivazione moderna, ma da tanti anni abbiamo il problema di poter vedere ciò che i direttori di fotografia hanno pensato in origine, solo che una volta sui tubi con l’immagine analogica le rielaborazioni erano limitate, oggi purtroppo si può massacrare ogni immagine oltre ogni limite della decenza.

https://youtu.be/kBTnOmIXnp4

comunque nel mio post sui formati dell’immagine potete trovare qualche riferimento su come una volta venissero tagliate anche le proporzioni video e selvaggiamente tagliate le inquadrature per adattarle prima al 4:3 poi a rovescio per adattare al 16:9 filmati girati con aspect ratio più vicino al 3:2 (super16mm).

Invece per chi è dubbioso, feci tempo fà un post tra pellicola e digitale, le differenze effettive in ripresa e resa dei due media, sfido tante persone di distinguere al cinema quali sequenze sono girate in pellicola, quali in digitale e poi stampate su pellicola, etc… la maggior parte delle persone non si accorge di come i film contengano una miscelazione ampia di diversi media, analogici, digitali etc.

Sono sicuro che se Kubrick fosse ancora vivo, non solo avrebbe abbracciato il digitale, ma sarebbe stato così cocciutamente testardo da far creare per lui un sistema di check dei proiettori digitali e dei televisori per far vedere correttamente le immagini dei suoi film, cosa tecnicamente fattibile da anni, ma che a quanto pare non sembra interessare a nessuno, e questa non è una mia elucubrazione, ma alle prime di molti suoi film si preoccupava che la proiezione fosse a livello qualitativo eccellente per esaltare il lavoro da lui fatto svolgere, quindi se lo fece per la pellicola, lo avrebbe fatto fare anche per il digitale.

Nota a margine: la schiava Isaura, la prima telenovelas ufficiale della storia della tv era girata in pellicola, quindi ironicamente poco telenovelas come stile visivo.